Голосовой AI для колл-центра

On-prem голосовой AI-оператор закрывает 72% звонков без человека за 0.96 с со снижением стоимости на 58%.

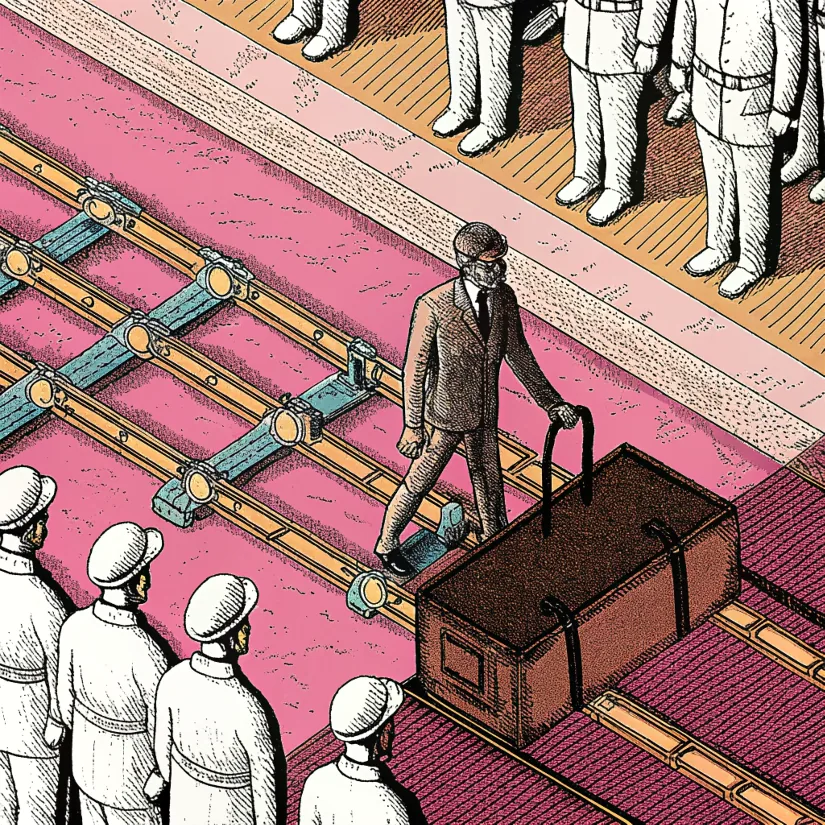

Проблема: 600 мест в контакт-центре, ожидание 9 минут, штрафы за SLA и новые требования AI Act, регламенты устаревают быстрее, чем успевают учить операторов.

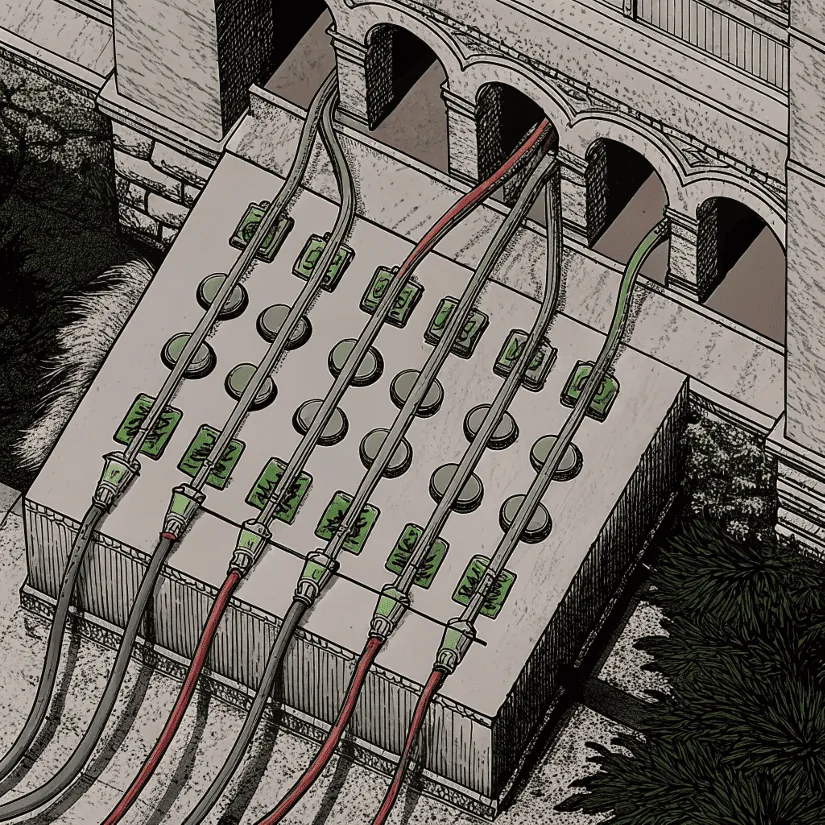

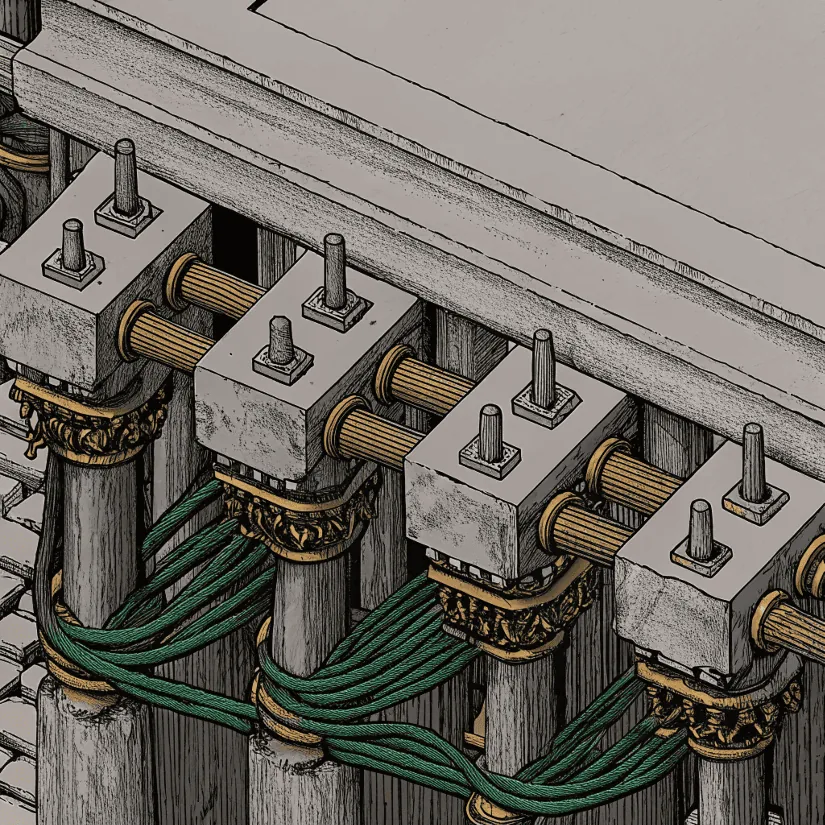

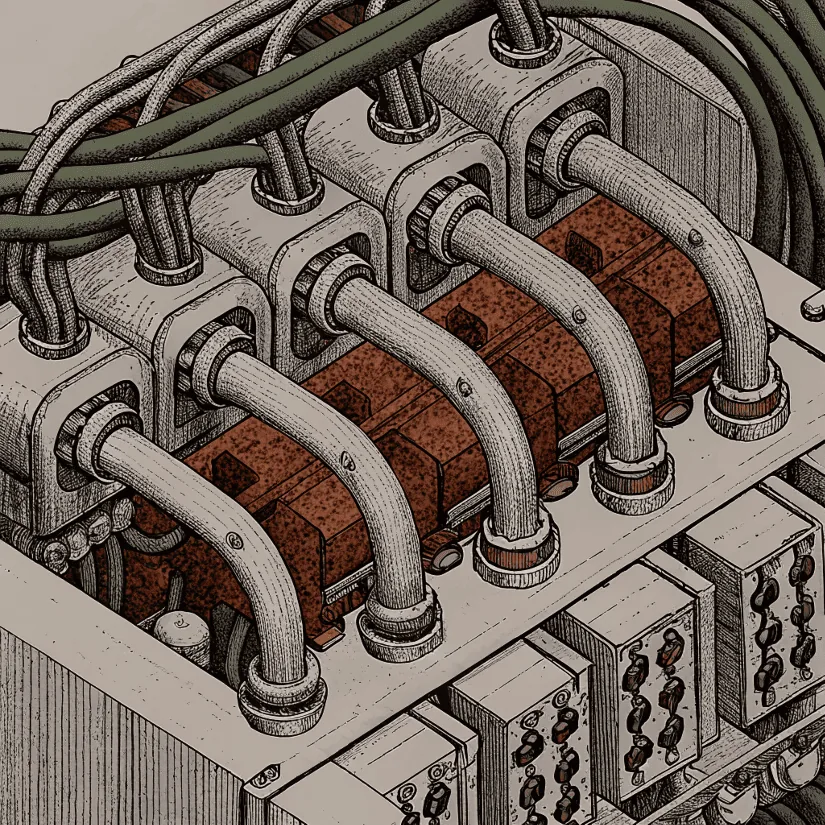

Решение: On-prem стек со стримингом, каскадом моделей, оркестрацией и базой знаний. Правила безопасности и ручная эскалация.