MLOps для production ML: 7 релизных гейтов для управляемой выкладки

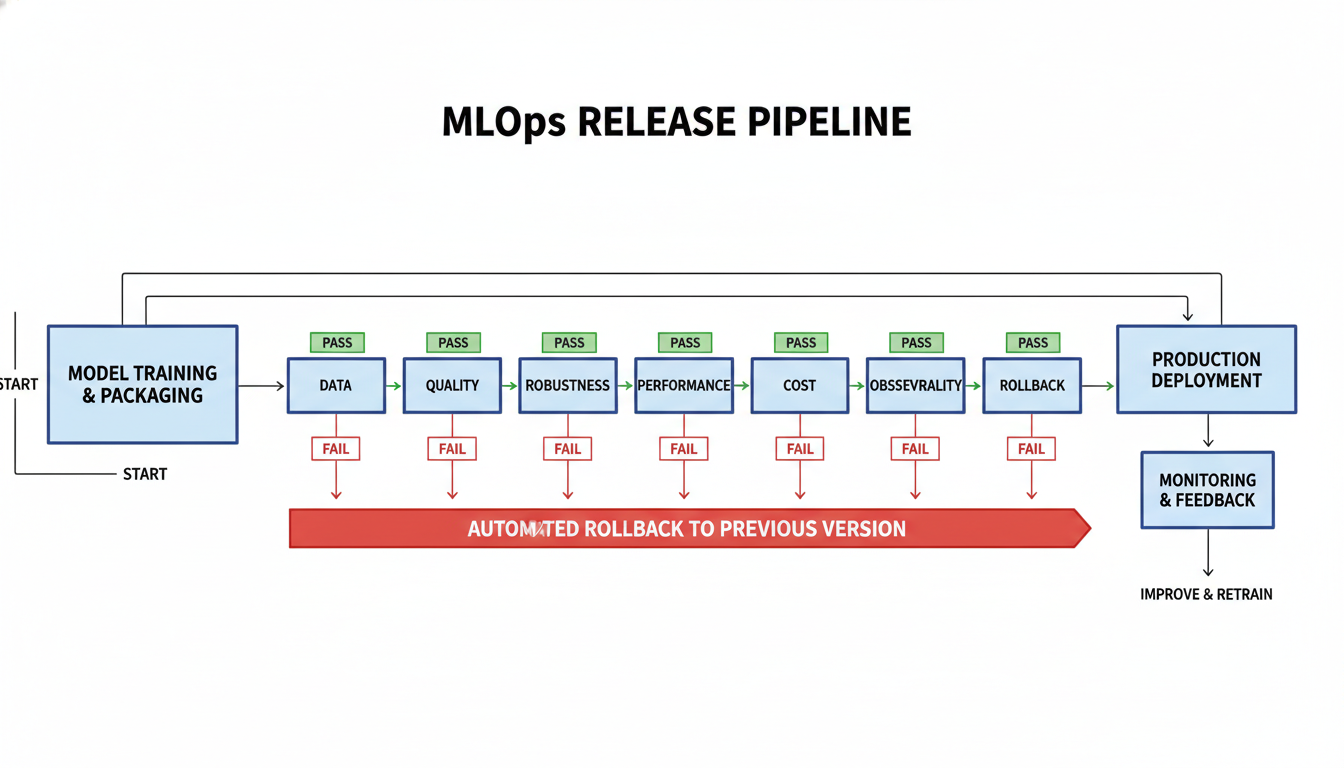

TL;DR: Production ML ломается в точке перехода от “валидно в ноутбуке” к “стабильно в сервисе”. Рабочий контур MLOps это не один дашборд, а набор жестких релизных гейтов: данные, качество, устойчивость, производительность, стоимость, наблюдаемость и откат. Если хотя бы один гейт не пройден, релиз не выходит в трафик.

В production модель является только частью релиза. На результат влияют код предобработки, версия признаков, конфигурация инференса, правила постобработки и режим выкладки. Именно поэтому “метрика выросла на валидации” сама по себе не означает готовность к реальному трафику.

Ниже практический каркас, который можно запускать в CI/CD без ручной интерпретации. Он опирается на проверяемые критерии и оставляет минимум серых зон в момент релиза.

Что считать единицей релиза

Стабильный релиз ML это связка артефактов, а не один model.bin:

- версия модели и ее сигнатура;

- код feature-пайплайна и схема входа;

- правила постобработки и бизнес-пороги;

- инфраструктурный профиль инференса;

- набор релизных гейтов с порогами.

Если любой из этих элементов меняется, это новый релиз и полный цикл проверок повторяется.

Где реально ломается production ML

На практике инциденты чаще возникают не из-за “плохой” нейросети, а из-за разрыва между средами:

- training-serving skew: данные в проде отличаются от обучающего контура;

- метрика выбрана неверно: офлайн растет, бизнес-эффект падает;

- latency стабильна на тестовом стенде, но проседает под пиком;

- стоимость растет после выкладки из-за новых входных распределений;

- rollback формально есть, но не восстанавливает старый рабочий контур целиком.

Эти риски закрываются дисциплиной релиза, а не заменой модели.

Опорная схема: 7 релизных гейтов

Схема 7 релизных гейтов: все критичные проверки до вывода модели в трафик.

| Gate | Что проверяется | Что блокирует релиз |

|---|---|---|

| 1. Гейт данных | схема, свежесть, валидность, сдвиг входа | неконсистентные или устаревшие данные |

| 2. Гейт качества | метрики задачи и срезов против базовой версии | регресс качества или калибровки |

| 3. Гейт устойчивости | граничные сценарии, отказоустойчивость, проверка политик | хрупкое поведение на граничных кейсах |

| 4. Гейт производительности | p95/p99 latency, throughput, доля таймаутов | нарушение SLO под рабочей нагрузкой |

| 5. Гейт стоимости | стоимость полезного результата | неокупаемый релиз при целевом качестве |

| 6. Гейт наблюдаемости | трассировка, метрики, алерты, владельцы | слепая эксплуатация после выкладки |

| 7. Гейт отката | атомарный откат и проверенный операционный регламент | риск долгого простоя при инциденте |

Каждый гейт бинарный: pass или fail. Формулировка “почти проходит” к production не применяется.

Гейт 1: данные

Гейт данных проверяет, что вход в модель воспроизводим и операционно пригоден.

Минимум для релиза:

- совместимость схемы по обязательным полям и типам;

- свежесть по SLA для всех критичных источников;

- базовые проверки качества: null/range/enum/outlier;

- контроль сдвига на ключевых признаках относительно опорного распределения.

Для drift-проверок обычно достаточно статистических тестов по типам колонок. Например, в Evidently это уже собрано в стандартные drift-механики для табличных и текстовых полей: docs.evidentlyai.com/metrics/explainer_drift.

Гейт 2: качество

Гейт качества защищает от ложного улучшения “средней температуры”. Проверяется не одна агрегированная метрика, а минимум три слоя:

- основная метрика задачи;

- контрольные срезы по важным сегментам трафика;

- калибровка или стабильность ранжирования.

Практическое правило:

- классификация:

PR-AUC/F1плюс калибровка (BrierилиECE); - регрессия:

MAE/RMSEплюс ошибка по ключевым диапазонам цели; - ранжирование/реком:

NDCG@K/Recall@Kплюс деградация по cold-slice.

Если модель выигрывает на общей выборке, но проваливает критичный slice, релиз блокируется.

Что считать доказанным улучшением

Чтобы гейт качества не пропускал случайные флуктуации, нужен статистический контракт:

- фиксируется минимальный объем выборки для сравнения;

- задается допустимая граница деградации

deltaдля non-inferiority проверки; - решение принимается по доверительному интервалу, а не по одной точке метрики.

Рабочее правило:

pass, если lower_95(metric_new - metric_base) > -deltaЕсли это условие не выполняется, релиз не проходит даже при визуально “похожих” метриках.

Гейт 3: устойчивость

Этот гейт отделяет “точную” модель от “живучей” системы.

Что должно быть в минимальном наборе:

- наборы граничных сценариев: пропуски, редкие категории, экстремальные диапазоны;

- проверка поведения при деградации внешних зависимостей;

- фолбэк-сценарии при timeout или пустом feature-response;

- проверка политик для чувствительных действий и данных.

Для LLM/RAG-контуров сюда добавляется защита от инъекций и контроль небезопасных вызовов инструментов, но принцип тот же: проверяется не качество текста, а безопасное поведение системы.

Гейт 4: производительность

Производительность оценивается на профиле реального трафика, а не на локальном бенчмарке.

Минимальный набор:

p95/p99 latency;- throughput на пиковых нагрузках;

- доля таймаутов и ошибок;

- холодный старт и прогретый путь отдельно.

SLO фиксируется до релиза и не меняется по факту неудачного прогона. Для алертинга по SLO практично использовать burn-rate подход из SRE Workbook: sre.google/workbook/alerting-on-slos.

Гейт 5: стоимость

Оценка по “стоимости запроса” часто вводит в заблуждение. Управляемая метрика это стоимость полезного исхода.

cost_per_useful_result =

(inference_cost + infra_cost + storage_cost + retraining_cost + human_ops_cost) / success_countПолезно фиксировать два порога:

- жесткий лимит стоимости полезного исхода;

- защитный порог на рост стоимости относительно текущей базовой версии в production.

Так релиз не пройдет даже при росте качества, если экономика становится хуже целевого уровня.

Как считать стоимость без самообмана

Одна формула без правил учета создает ложную точность. Поэтому перед релизом фиксируются:

- горизонт расчета:

7dдля оперативного контроля и30dдля финансового решения; - правила аллокации фиксированных затрат по доле трафика сервиса;

- отдельный учет разовых миграционных затрат, чтобы не смешивать их с steady-state.

Минимальный рабочий набор:

cost_per_useful_result_7d

cost_per_useful_result_30dРелиз проходит, только если обе метрики укладываются в порог и не ухудшают экономику базовой версии.

Гейт 6: наблюдаемость

Если нельзя быстро локализовать причину деградации, observability фактически отсутствует.

Минимум должен покрывать четыре плоскости:

- инфраструктура: CPU/GPU, память, saturation, сетевые ошибки;

- модель: распределения предсказаний, drift, прокси качества;

- продукт: доля успешных сценариев, эскалации, отмены;

- экономика: стоимость по модели, сервису, сегменту трафика.

Обязательное требование: единый trace_id между gateway, feature lookup, inference и post-processing.

Практический профиль SLO-алертов

Для сервисов с SLO 99.9% хорошо работает многооконная схема burn-rate. В операционной практике это снижает шум и одновременно не пропускает долгие деградации.

Базовый стартовый профиль:

- page: burn-rate 14.4, окна 1h и 5m;

- page: burn-rate 6, окна 6h и 30m;

- ticket: burn-rate 1, окна 3d и 6h.

Эти числа валидны как стартовый профиль для SLO 99.9% и стандартной модели error budget. Для низкого трафика и пакетных систем пороги пересчитываются отдельно, иначе возможны ложные тревоги.

Гейт 7: откат

Откат считается готовым только если операция атомарна для всего релиза:

- модель;

- код предобработки;

- конфигурация порогов;

- зависимые сервисные параметры.

Критерии готовности:

- откат запускается одной операцией;

- есть последняя стабильная версия всех артефактов;

- RTO отката измерен на учении, а не оценен экспертно;

- операционный регламент (runbook) имеет владельца и проверен на симуляции инцидента.

Без этих условий rollback не снижает риск простоя.

Антипаттерны, которые релиз должен блокировать

Ниже список сигналов, при которых выкладка останавливается без обсуждений:

- “переобучили модель, но не зафиксировали версию feature-кода”;

- “прошел offline eval, но не запускали canary”;

- “алерты есть, но владельцы и операционный регламент не назначены”;

- “стоимость полезного исхода не считали, оценивали только цену запроса”;

- “план отката существует, но не проверялся на учении”.

Если хотя бы один пункт выполняется, это технический долг до релиза, а не после релиза.

Контракт релиза: что хранить в CI/CD

Ниже минимальный пример паспорта релиза, который делает выкладку проверяемой и воспроизводимой.

release_id: ml-2025-12-26.3

artifacts:

model_uri: models:/churn-model@candidate

feature_pipeline: feature-pipeline:v18

preprocessing_image: registry/preproc:1.12.4

postprocessing_config: thresholds:v9

gates:

data_gate: pass

quality_gate: pass

robustness_gate: pass

performance_gate: pass

cost_gate: pass

observability_gate: pass

rollback_gate: pass

rollout:

strategy: canary

steps: [5, 25, 50, 100]

auto_rollback_on:

- p99_latency_ms > 800

- error_rate > 0.8%

- cost_per_useful_result > 0.42Это простая структура, но она резко снижает шанс “устного” релиза без ответственности.

Быстрая проверка релиза: 12 вопросов перед выкладкой

Если хотя бы на один вопрос ответ “нет”, релиз не выходит:

- Есть воспроизводимый пакет артефактов релиза.

- Data gate пройден на актуальном срезе входа.

- Quality gate пройден на baseline и критичных сегментах.

- Robustness gate пройден на edge-наборах.

- Performance gate пройден под профилем целевой нагрузки.

- Cost gate укладывается в бюджет полезного исхода.

- Наблюдаемость покрывает путь от запроса до ответа.

- SLO-алерты настроены и привязаны к владельцам.

- Canary-план и критерии автоотката зафиксированы.

- Rollback протестирован, RTO измерен.

- Операционный регламент инцидента обновлен под текущий релиз.

- Послерелизная проверка на 24 часа назначена.

Инструменты, которые закрывают базовый контур

В открытом стеке обычно достаточно следующего набора:

MLflowдля журналирования экспериментов и реестра моделей. Для новых контуров лучше использовать aliases и версионирование артефактов, а не старый stage-подход: mlflow.org/docs/latest.Prometheus + Grafanaдля системных и SLO-метрик.Evidentlyдля data/prediction drift и качества в отложенной оценке.- CI/CD оркестратор команды для автоматической проверки гейтов и выкладки.

В прикладном LLM-контуре этот же принцип разобран в статье про MLOps для RAG-агента поддержки.

План внедрения на 30 дней

Неделя 1: формализация релизной политики

- Зафиксировать SLO/SLA и бизнес-метрику полезного исхода.

- Определить единицу релиза и обязательные артефакты.

- Включить гейт данных и гейт качества в CI.

Неделя 2: эксплуатационная устойчивость

- Добавить гейт устойчивости и гейт производительности.

- Запустить нагрузочный профиль, близкий к production.

- Утвердить критерии блокировки релиза.

Неделя 3: наблюдаемость и экономика

- Подключить drift и quality-proxy мониторинг.

- Настроить SLO-алерты по burn-rate.

- Ввести гейт стоимости и еженедельный обзор по

cost_per_useful_result.

Неделя 4: безопасная выкладка и откат

- Запустить canary-процесс с автооткатом.

- Прогнать учебный инцидент и измерить фактический RTO.

- Закрыть postmortem с изменениями в гейтах.

После этого релиз перестает быть ручной операцией и становится инженерным процессом с измеримым качеством.

Где не усложнять

Для небольшого внутреннего сервиса на старте достаточно четырех гейтов: данные, качество, производительность, откат. Гейт стоимости и гейт наблюдаемости можно вводить поэтапно, но только при фиксированном владельце и сроке. Иначе “временное упрощение” быстро превращается в постоянный риск.

Итог

MLOps в production это система решений до и после выкладки модели. Сильная модель без дисциплины релиза дает нестабильный сервис. Контур из 7 гейтов дает управляемую выкладку: понятные критерии, воспроизводимость, быстрый откат и прозрачную экономику на уровне полезного результата.